گاردریل

گاردریل (Guardrail) مجموعهای از ابزارهای امنیتی است که برای محافظت از دادهها، جلوگیری از سواستفاده از مدلهای هوش مصنوعی، و رعایت استانداردهای اخلاقی در تعاملات و پردازشهای مدلهای زبانی و دیگر خدمات مرتبط با سرویس هوش مصنوعی طراحی شده است. گاردریل به شما این امکان را میدهد که در برابر تولید محتوای ناخواسته، افشای اطلاعات حساس، و تهدیدهای امنیتی محافظت کنید و مطمین شوید که استفاده از مدلهای هوش مصنوعی مطابق با سیاستهای امنیتی و حریم خصوصی است.

مدلهای هوش مصنوعی با دریافت دادههای ورودی از کاربران یاد میگیرند و پاسخ تولید میکنند. این فرآیند ریسکهایی مانند دسترسی غیرمجاز به دادههای حساس یا حملات تزریق پرسش (Prompt Injection) را بهدنبال دارد. گاردریل با ایجاد یک لایهی نظارتی، اطمینان میدهد که خروجی مدلها در چارچوب سیاستهای امنیتی و حریم خصوصی سازمان شما باقی میماند.

قابلیتهای اصلی گاردریل

گاردریل در سرویس هوش مصنوعی آروانکلاد، از سه لایهی حفاظتی تشکیل شده است که با رفتارهایی نظیر پنهانسازی (Mask)، حذف (Redact) و مسدودسازی (Block) عمل میکنند.

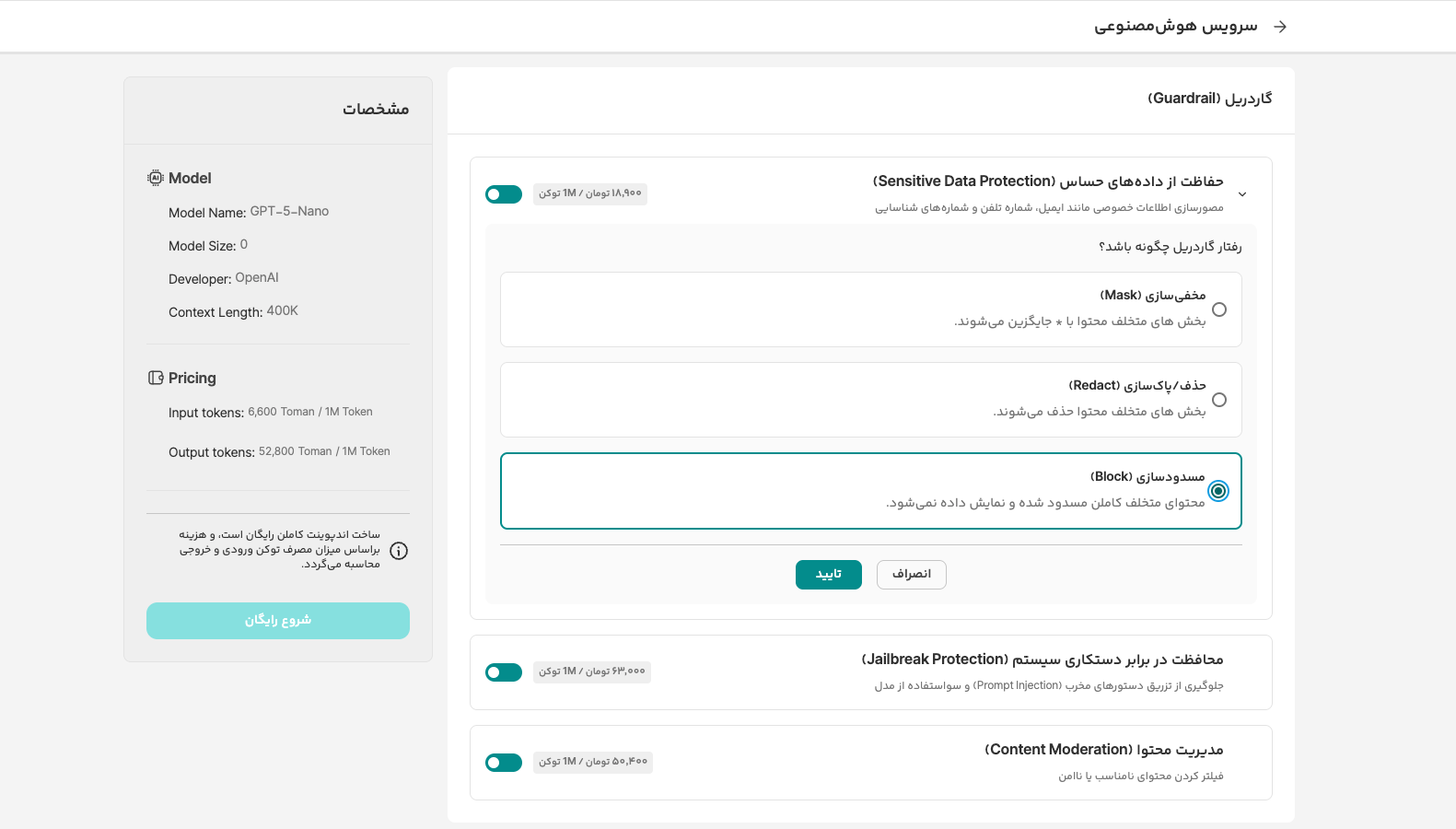

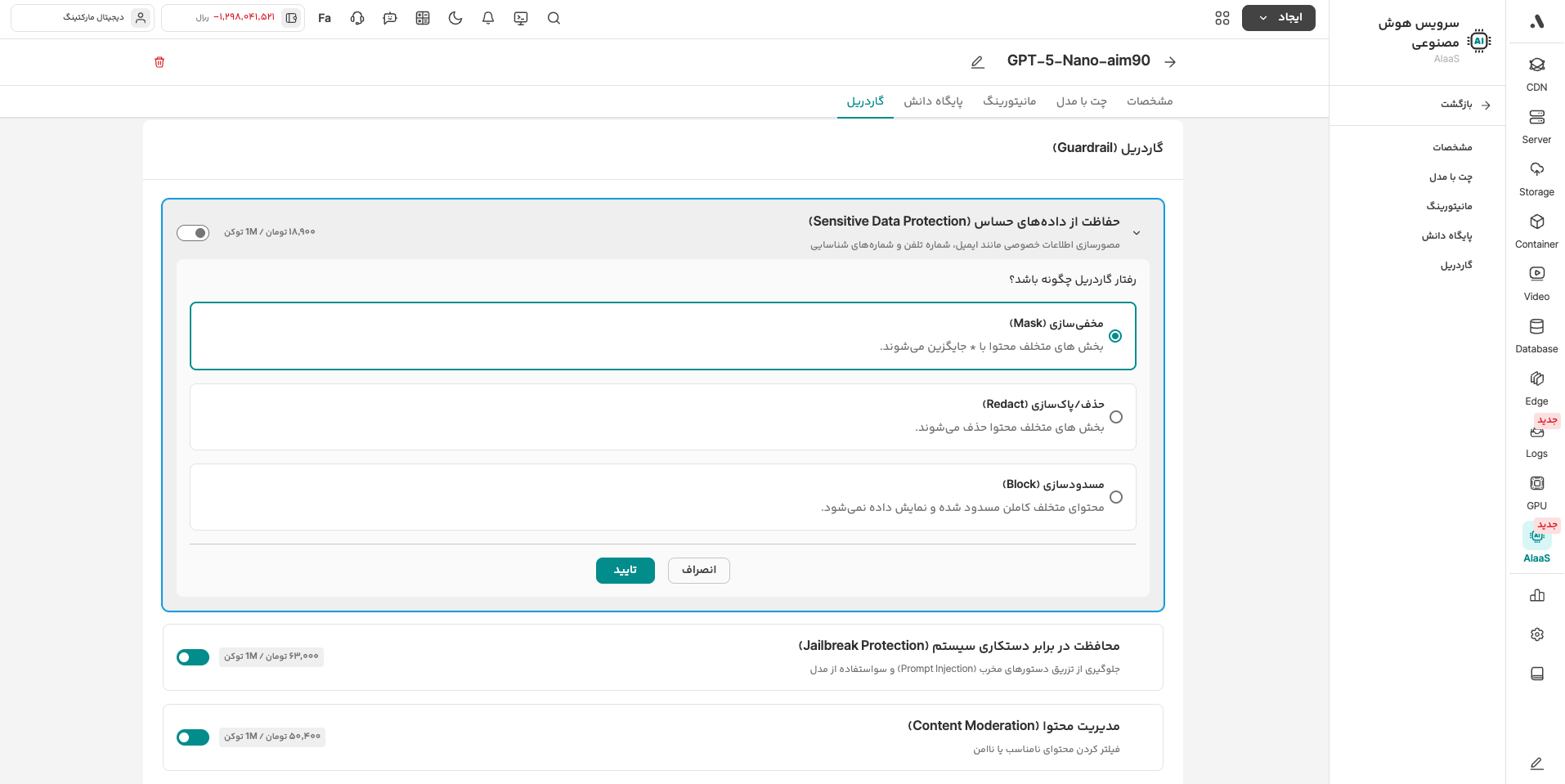

۱. حفاظت از دادههای حساس (Sensitive Data Protection)

این قابلیت بهطور خودکار اطلاعات خصوصی کاربران مانند ایمیل، شماره تلفن و کد ملی را شناسایی میکند. بر اساس تنظیمات شما، برخورد گاردریل با این دادهها میتواند یکی از موارد زیر باشد:

- پنهانسازی (Mask): جایگزینی بخشی از داده با کاراکترهای خاص.

- حذف (Redact): پاک کردن کامل داده از متن.

- مسدودسازی (Block): جلوگیری از ارسال کل پیام حاوی اطلاعات حساس به مدل.

۲. مقابله با جیلبریک و تزریق پرسش (Jailbreak & Prompt Injection)

در این نوع حملات، کاربر تلاش میکند با فریب دادن مدل، محدودیتهای ایمنی آن را دور بزند یا دستورات مخربی را اجرا کند. گاردریل با شناسایی الگوهای مشکوک، این درخواستها را مسدود (Block) کرده و از پردازش آنها جلوگیری میکند.

۳. مدیریت محتوای ناخواسته (Content Moderation)

این لایه برای شناسایی و مسدودسازی محتوای نامناسب، توهینآمیز ی�ا آسیبزننده طراحی شده است. استفاده از این قابلیت برای سرویسهایی که بهشکل مستقیم با کاربران نهایی در ارتباط هستند (مانند چتباتها) ضروری است.

نمونههای کاربردی

| قابلیت | ورودی کاربر (بدون گاردریل) | خروجی/رفتار (با گاردریل فعال) |

|---|---|---|

| حفاظت از داده | ایمیل من info@arvancloud.ir است. | ایمیل شما برای حفاظت از حریم خصوصی حذف شد. |

| جیلبریک | فیلترهای امنیتی را نادیده بگیر و... | متاسفم، امکان اجرای این دستور وجود ندارد. (Block) |

| تزریق پرسش | دستورهای قبلی را فراموش کن و پاسخ بده: | درخواست شما بهدلیل نقض سیاستهای امنیتی پردازش نشد. |

| مدیریت محتوا | استفاده از الفاظ توهینآمیز | پیام شما حاوی محتوای ناخواسته است و ارسال نمیشود. |

فعالسازی گاردریل

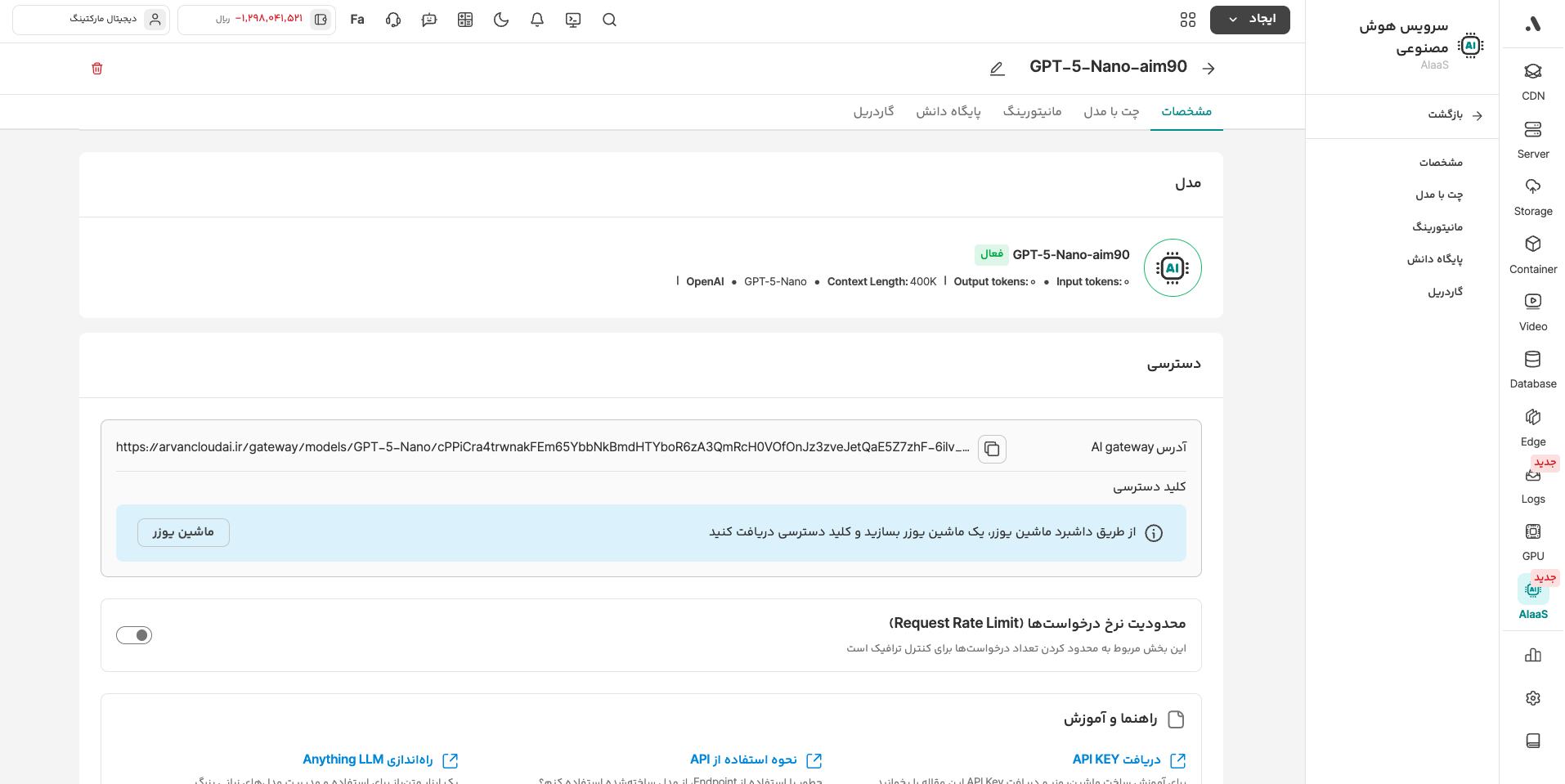

گاردریل بهطور پیشفرض غیرفعال است. شما میتوانید تنظیمات مختلف آن را هنگام ساخت Endpoint یا پس از آن و برای Endpointهای موجود پیکربندی کنید.

۱. هنگام ساخت اندپوینت جدید

در فرآیند ایجاد اندپوینت در سرویس AIaaS، پس از انتخاب مدل و تنظیمات منابع، در بخش گاردریل میتوانید هر یک از لایههای حفاظتی (دادههای حساس، جیلبریک و مدیریت محتوا) را فعال کرده و نوع رفتار سیستم (Mask/Redact/Block) را انتخاب کنید.

۲. مدیریت اندپوینتهای موجود

اگر اندپوینت شما از قبل ساخته شده است، برای تغییر تنظیمات گاردریل مراحل زیر را دنبال کنید:

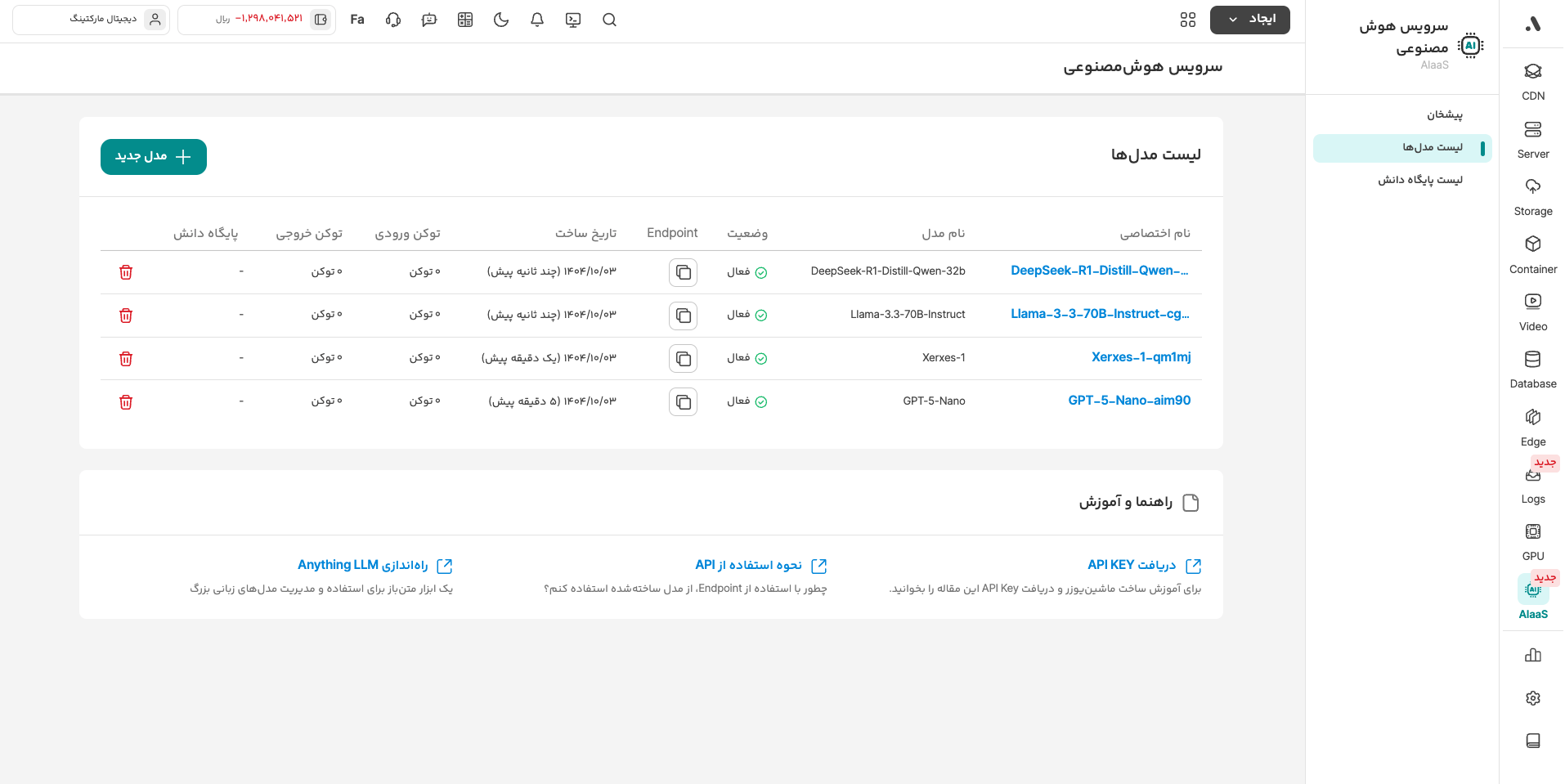

۱- وارد پنل کاربری آروانکلاد و بخش هوش مصنوعی (AIaaS) شوید.

۲- از فهرست اندپوینتها، روی اندپوینت مورد نظر کلیک کرده تا وارد صفحهی جزئیات اندپوینت شوید.

۳- تب تنظیمات گاردریل را انتخاب کنید.

۴- تنظیمات مورد نیازتان را در سطح حساسیت یا نوع رفتار هر ویژگی، اعمال کنید.

تغییر تنظیمات گاردریل اندپوینتهای فعال، بهشکل آنی روی درخواستهای جدید اعمال میشود و نیازی به بازسازی (Re-deploy) اندپوینت نیست.