استفاده از n8n

n8n یک ابزار خودکارسازی (Automation) متنباز است که به شما امکان میدهد با استفاده از یک رابط گرافیکی یا Visual Workflow Editor، انواع فرآیندها را بین سرویسها و APIهای مختلف بهشکل خودکار اجرا کنید. این ابزار از یک ساختار مبتنی بر Node استفاده میکند که هر Node میتواند یک عملیات مانند دریافت داده از یک API، پردازش اطلاعات، یا ارسال پیام به یک سرویس دیگر را انجام دهد.

n8n را میتوان هم بر بستر کلاد و هم بهش�کل Self-hosted اجرا کرد. انعطافپذیری بالا و امکان نوشتن کدهای سفارشیسازیشده برای هر Node، این ابزار را میان توسعهدهندگان و تیمهای فنی بسیار محبوب کرده است.

نصب n8n

با توجه به زیرساختی که میخواهید n8n را روی آن نصب کنید میتوانید یکی از روشهای زیر را انتخاب کنید:

-

سادهترین راهکار نصب n8n استفاده از کانتینر ابری آروانکلاد است. برای نصب n8n تنها با چند کلیک میتوانید از لینک زیر استفاده کنید:

-

نصب با

npx: -

نصب با

docker:

اتصال n8n به سرویس هوش مصنوعی آروانکلاد

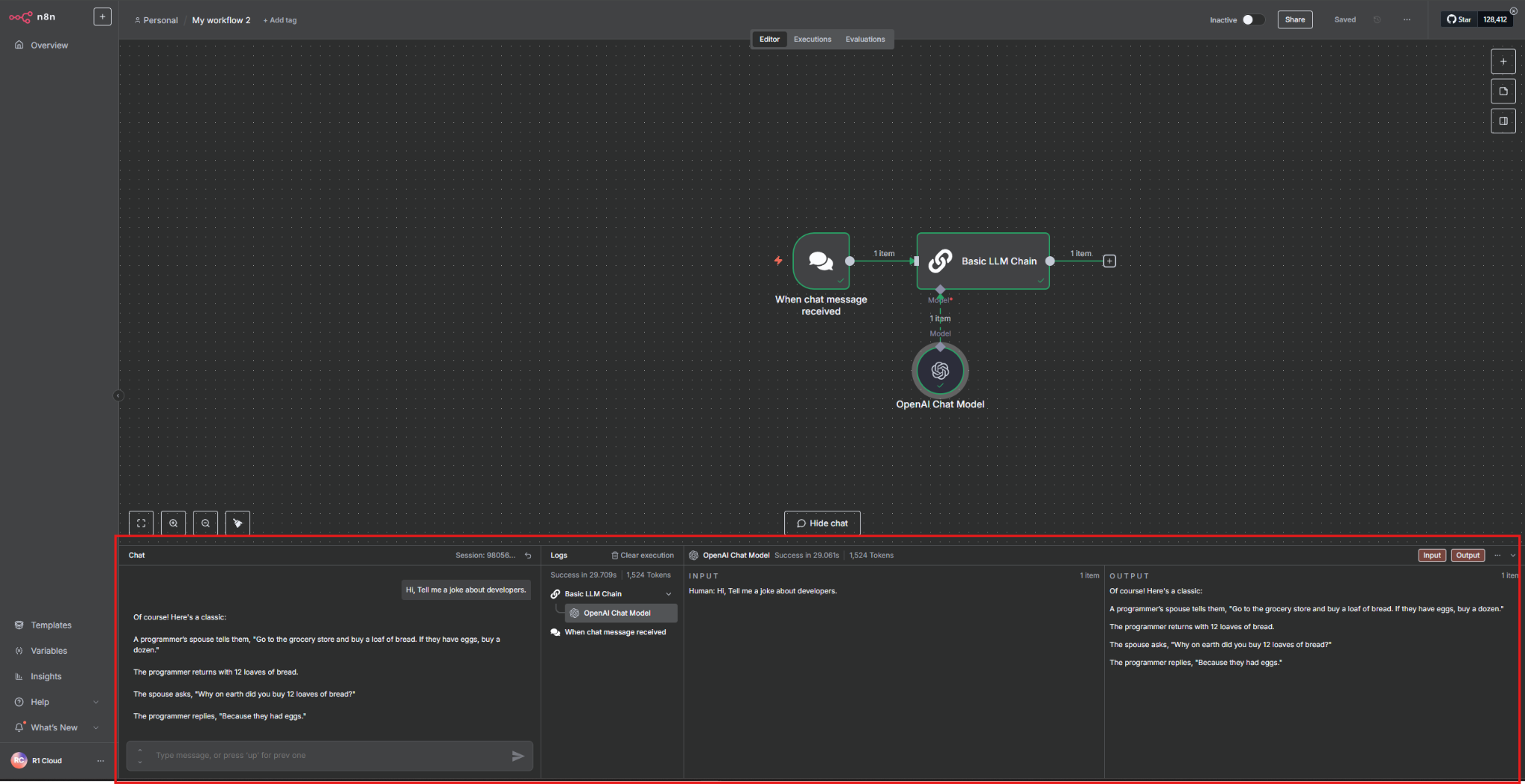

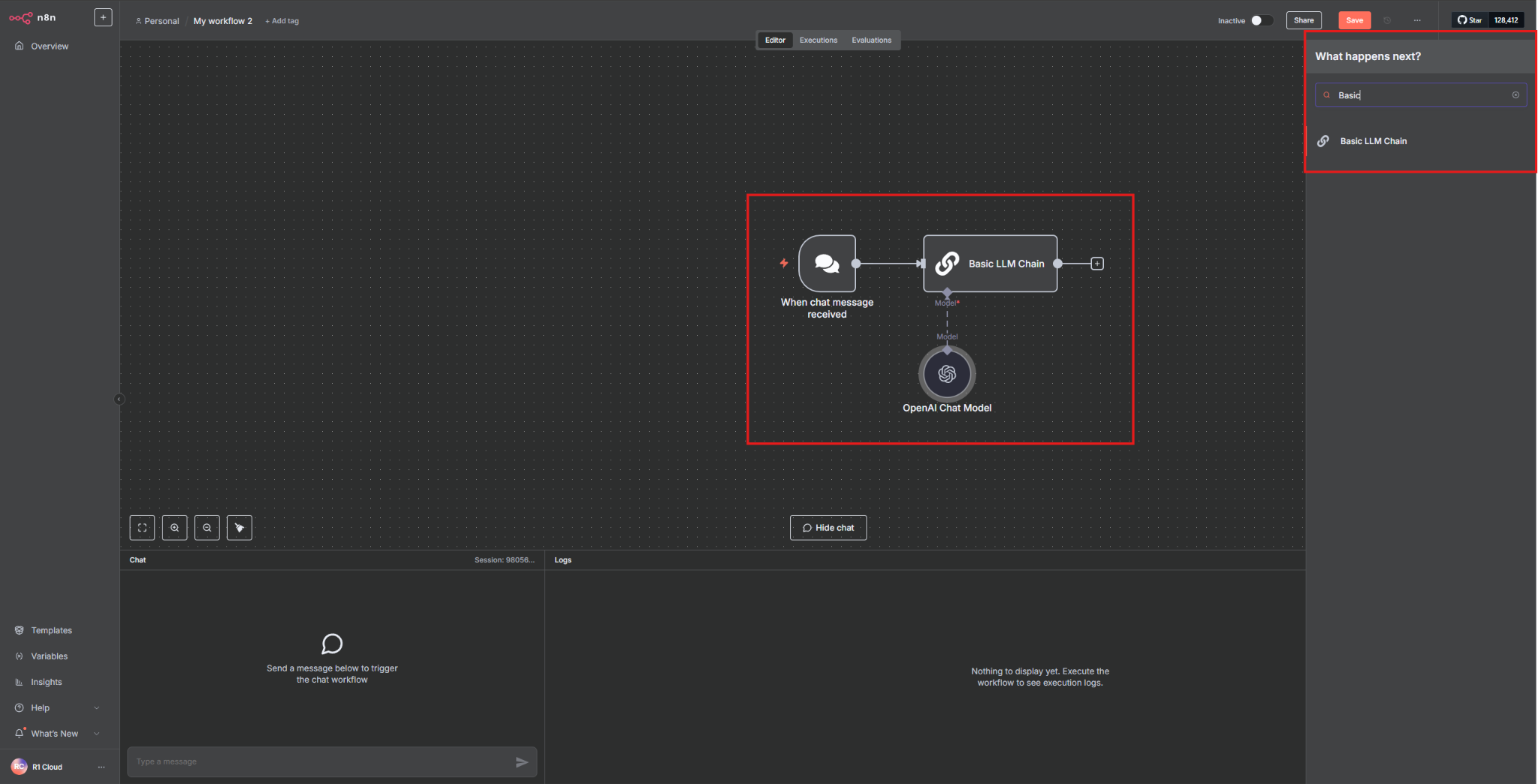

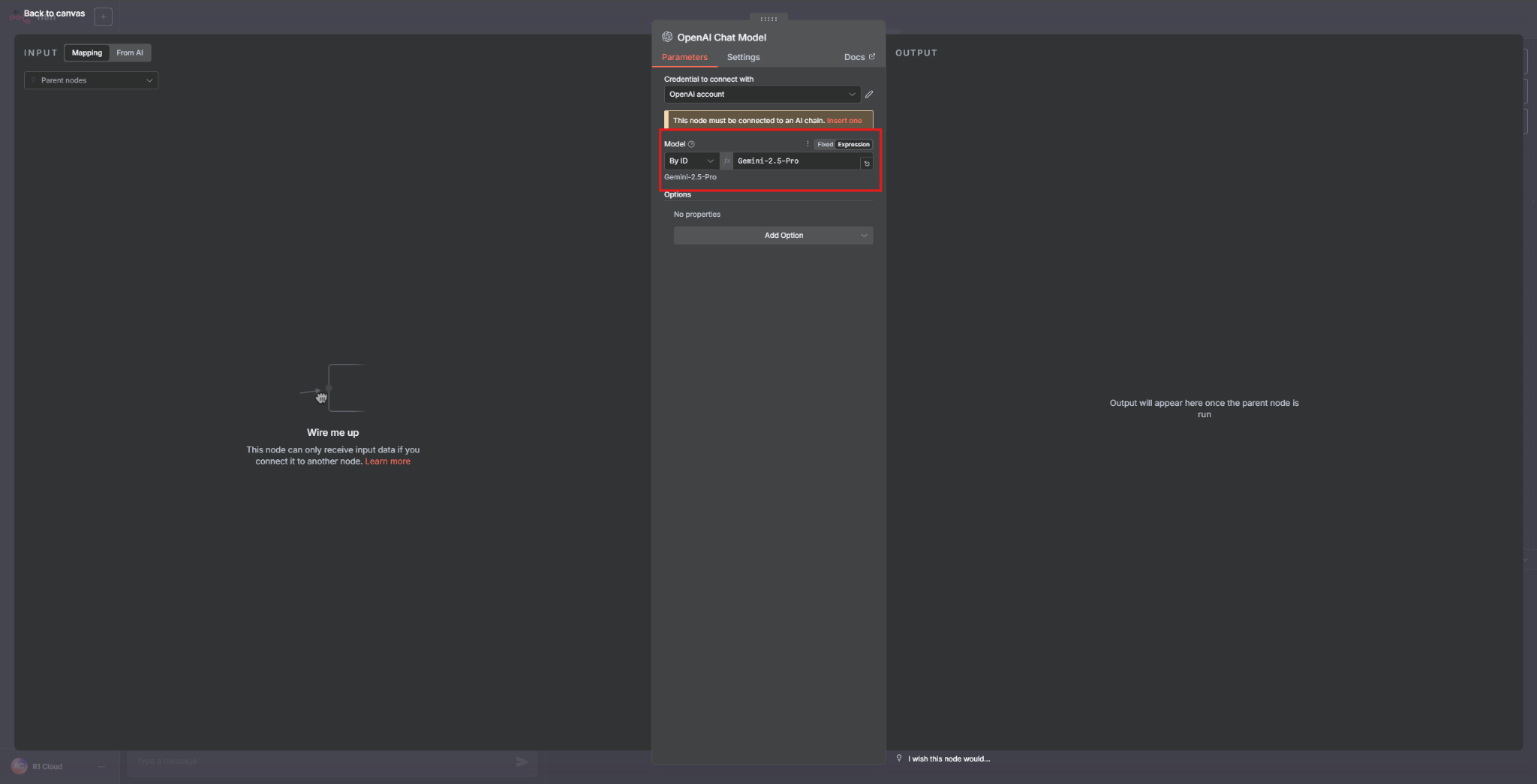

ابتدا یک Chat Trigger اضافه کنید، سپس با اضافه کردن Basic LLM Chain و OpenAI Chat Model، آنها را مطابق تصویر به هم متصل کنید:

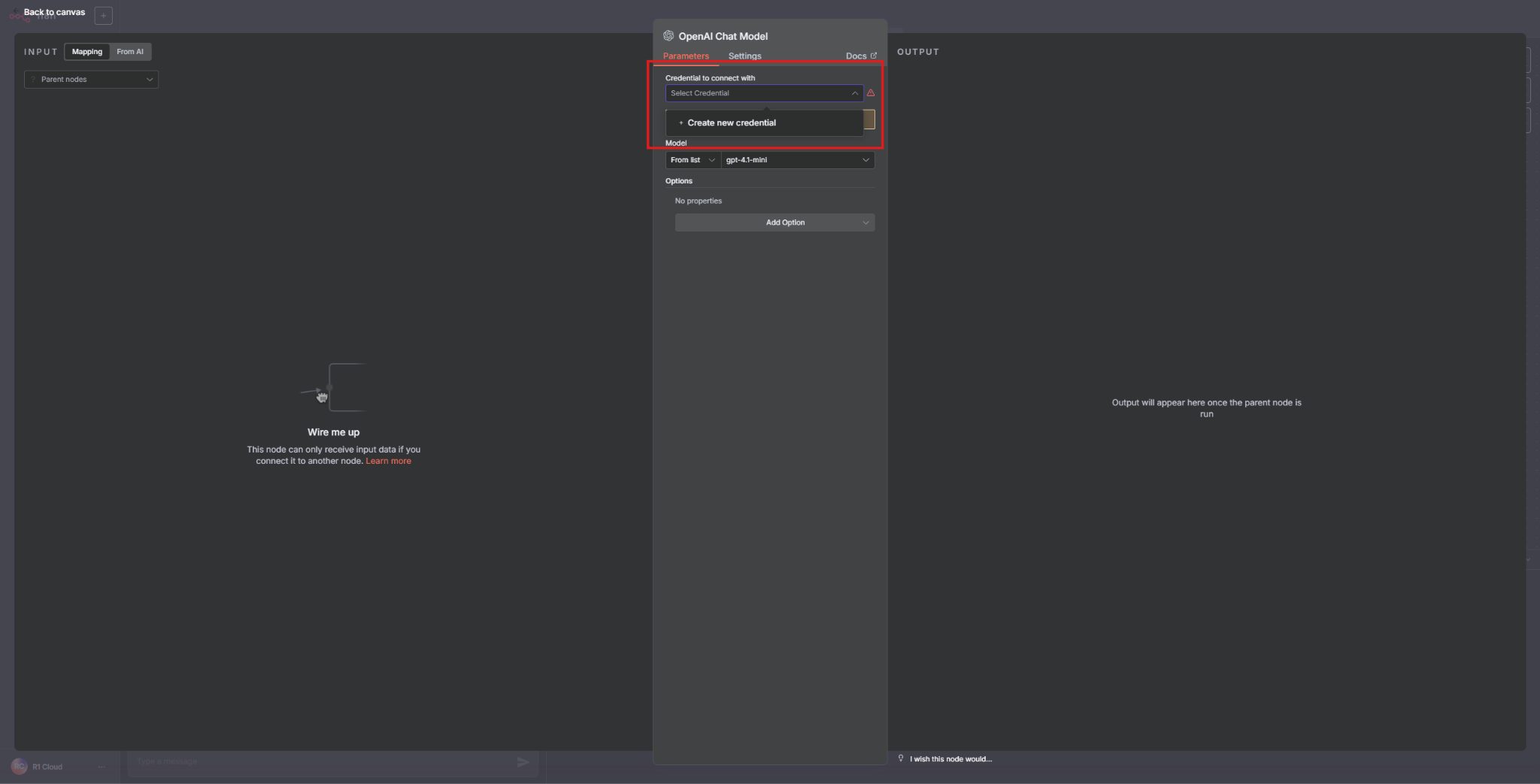

در تنظیمات OpenAI Chat Model یک Credential جدید ایجاد کنید.

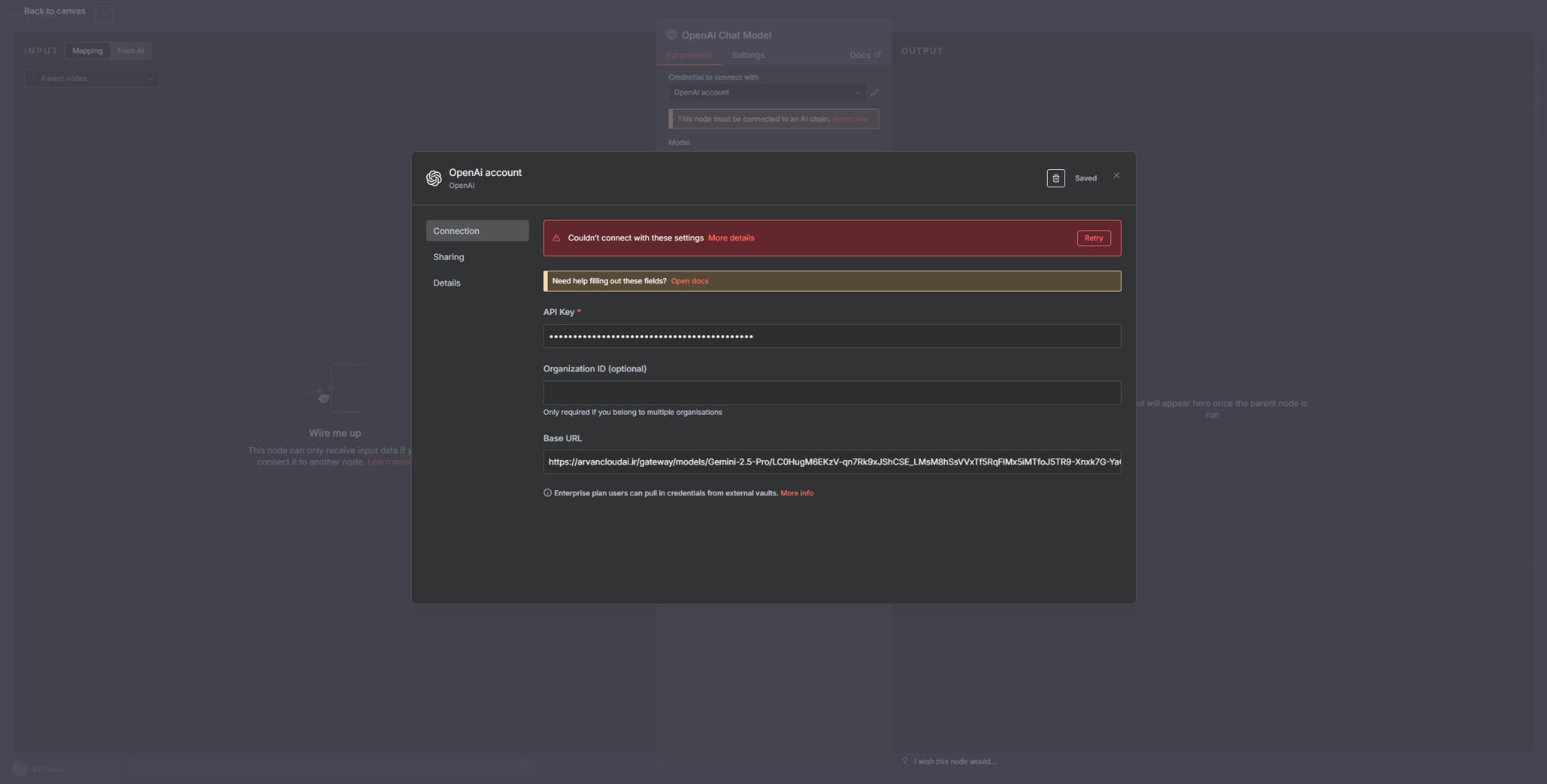

سپس API Key و آدرس URL اندپوینتی که در پنل کاربری آروان برای سرویس هوش مصنوعی ساختهاید در این قسمت قرار دهید:

برای دریافت این مقادیر میتوانید از راهنمای ساخت Endpoint کمک بگیرید.

روی دکمهی Save کلیک کنید.

در این مرحله اگر با خطایی مواجه شدید، آن را نادیده بگیرید.

با کلیک روی دکمهی بازگشت، نوع مدل را از Fixed به Expression تغییر دهید:

اکنون میتوانید در پایین صفحه با مدل چت کنید.